Déploiement des Modules Multimodes NDR

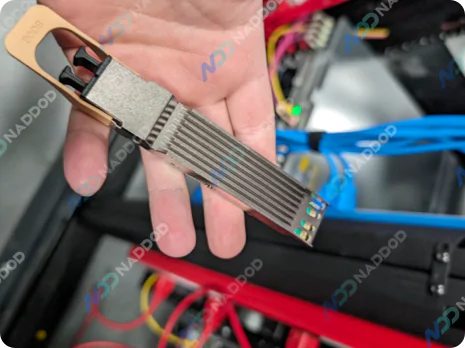

Les émetteurs-récepteurs multimodes InfiniBand NDR offrent des performances économiques et fiables sur de courtes distances.

Le routage adaptatif, le calcul en réseau et l'architecture de contrôle de congestion permettent à InfiniBand de répondre aux exigences rigoureuses des clusters HPC et IA. Ces optimisations garantissent un flux de données transparent, éliminent les goulots d'étranglement et permettent une utilisation efficace des ressources, ce qui se traduit par des performances supérieures et une efficacité opérationnelle accrue pour les infrastructures complexes.

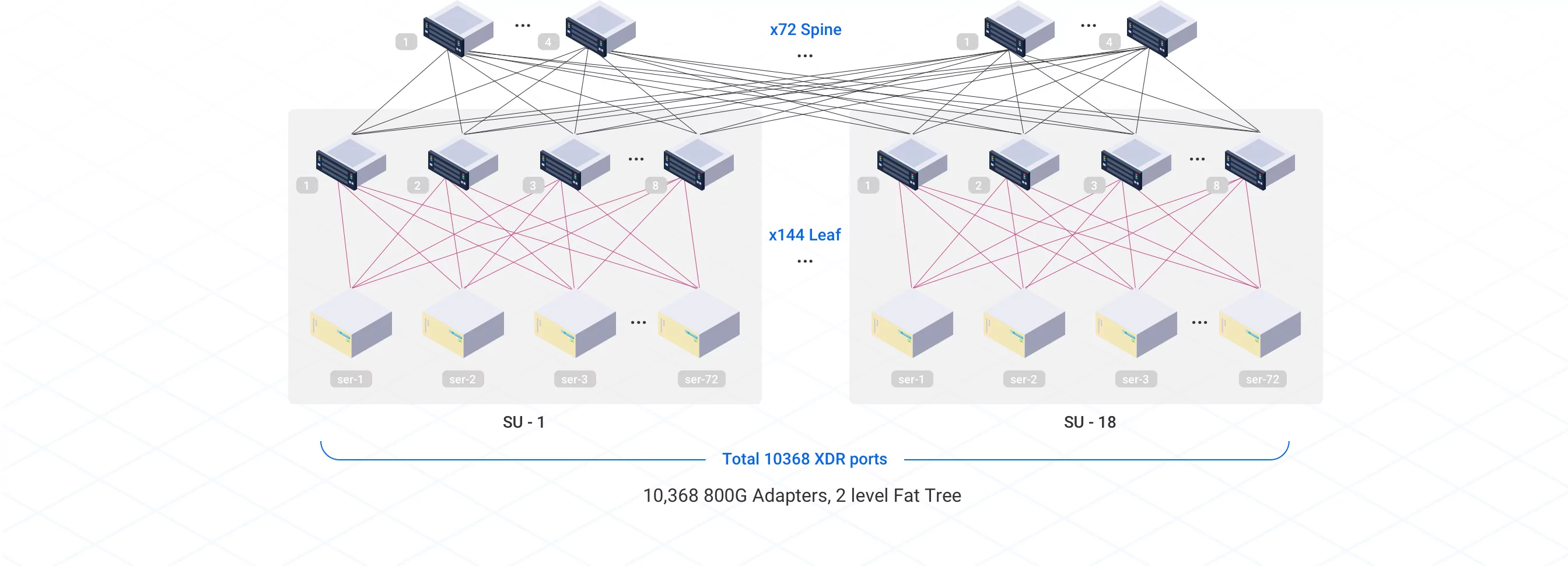

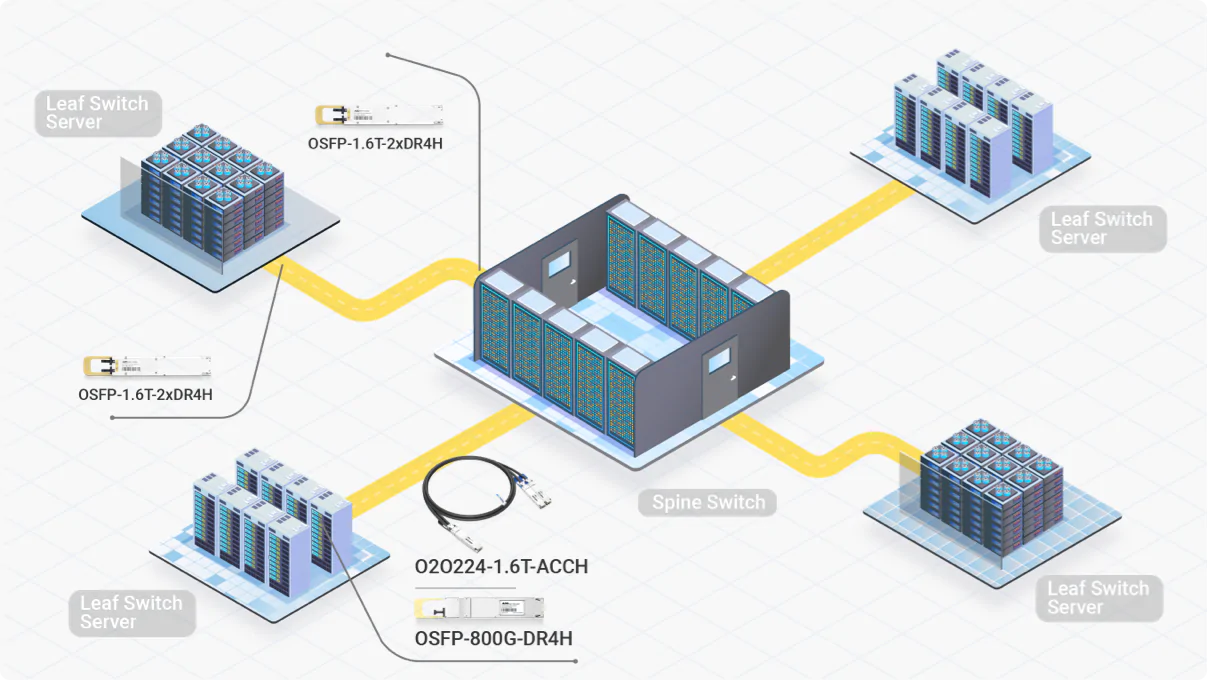

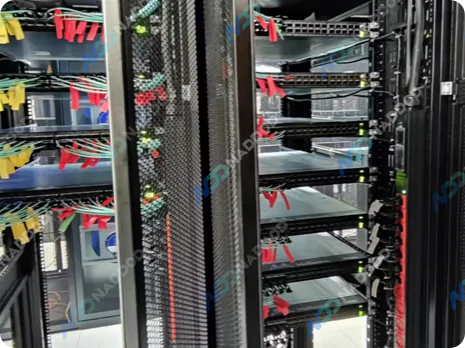

Pour le déploiement de clusters IA InfiniBand à grande échelle, avec les GPU NVIDIA H100, H200, les solutions DGX (GB200, GB300), les topologies réseau en arbre gras sont associées à ceux-ci, ce qui convient au traitement des charges de travail IA intensives.

Solutions flexibles adaptées aux différentes tailles de clusters d'IA, aux agencements des centres de données et aux distances de connexion.

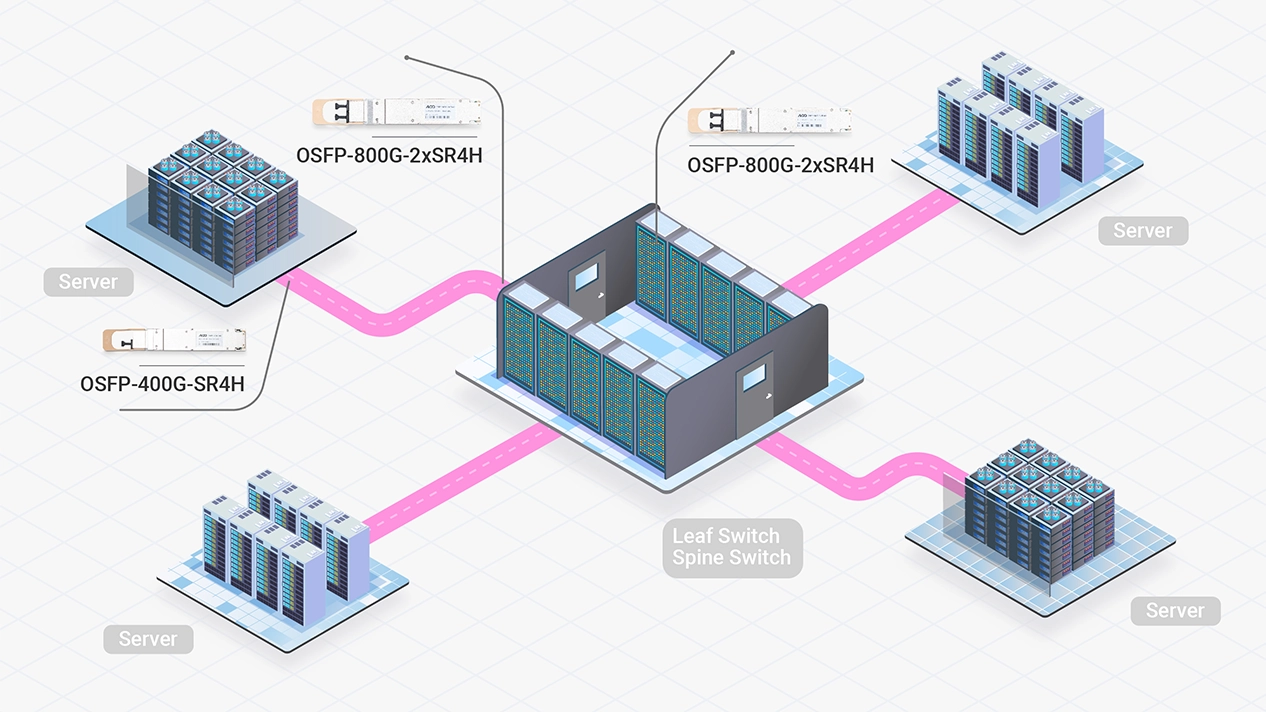

Déploiement de réseau InfiniBand hautes performances conçu pour les centres de données IA compacts

Les émetteurs-récepteurs multimodes InfiniBand NDR offrent des performances économiques et fiables sur de courtes distances.

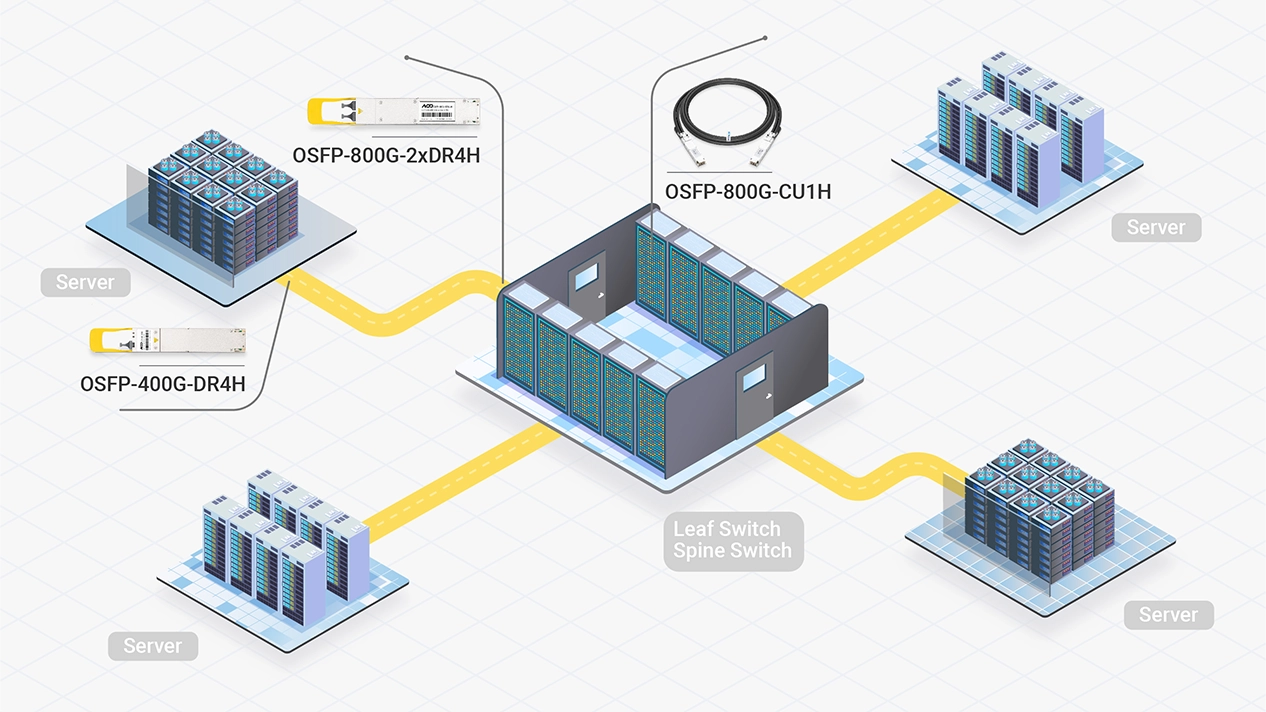

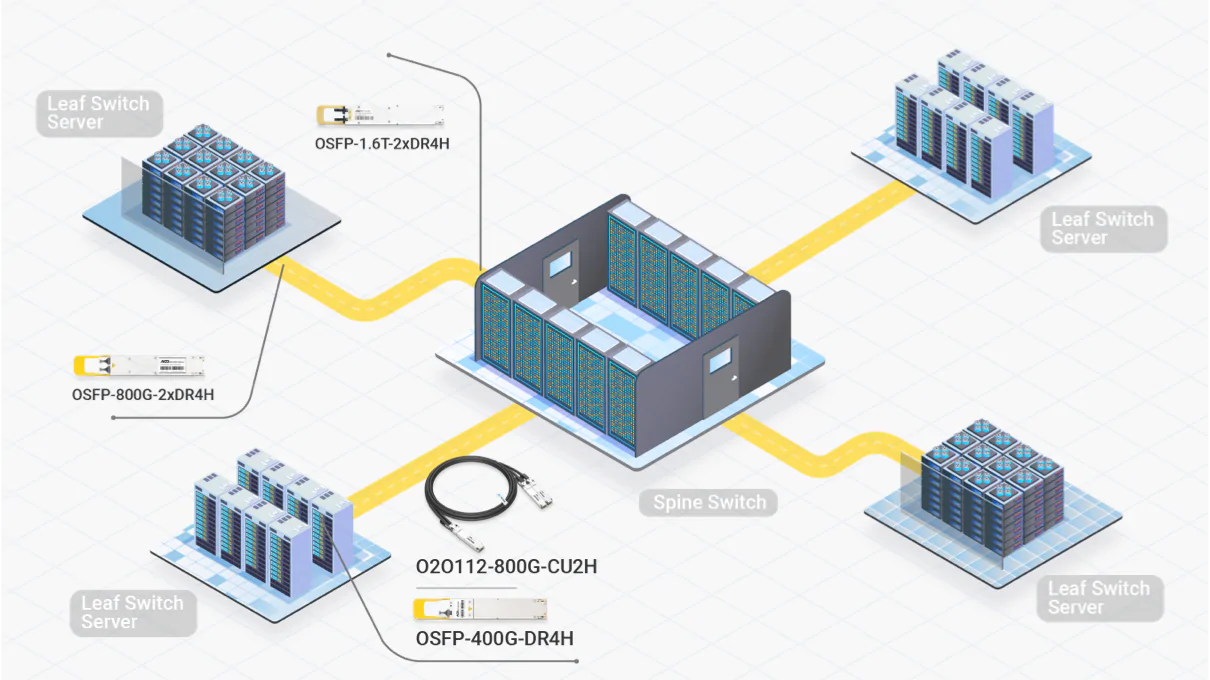

Une solution haute performance et économique pour mettre à niveau ou construire des clusters d'IA plus évolutifs.

Les émetteurs-récepteurs InfiniBand NDR monomodes permettent des connexions stables sur de longues distances, tandis que les câbles DAC réduisent les coûts et la consommation d'énergie. Ensemble, ils offrent une solution efficace pour les clusters de taille moyenne à grande.

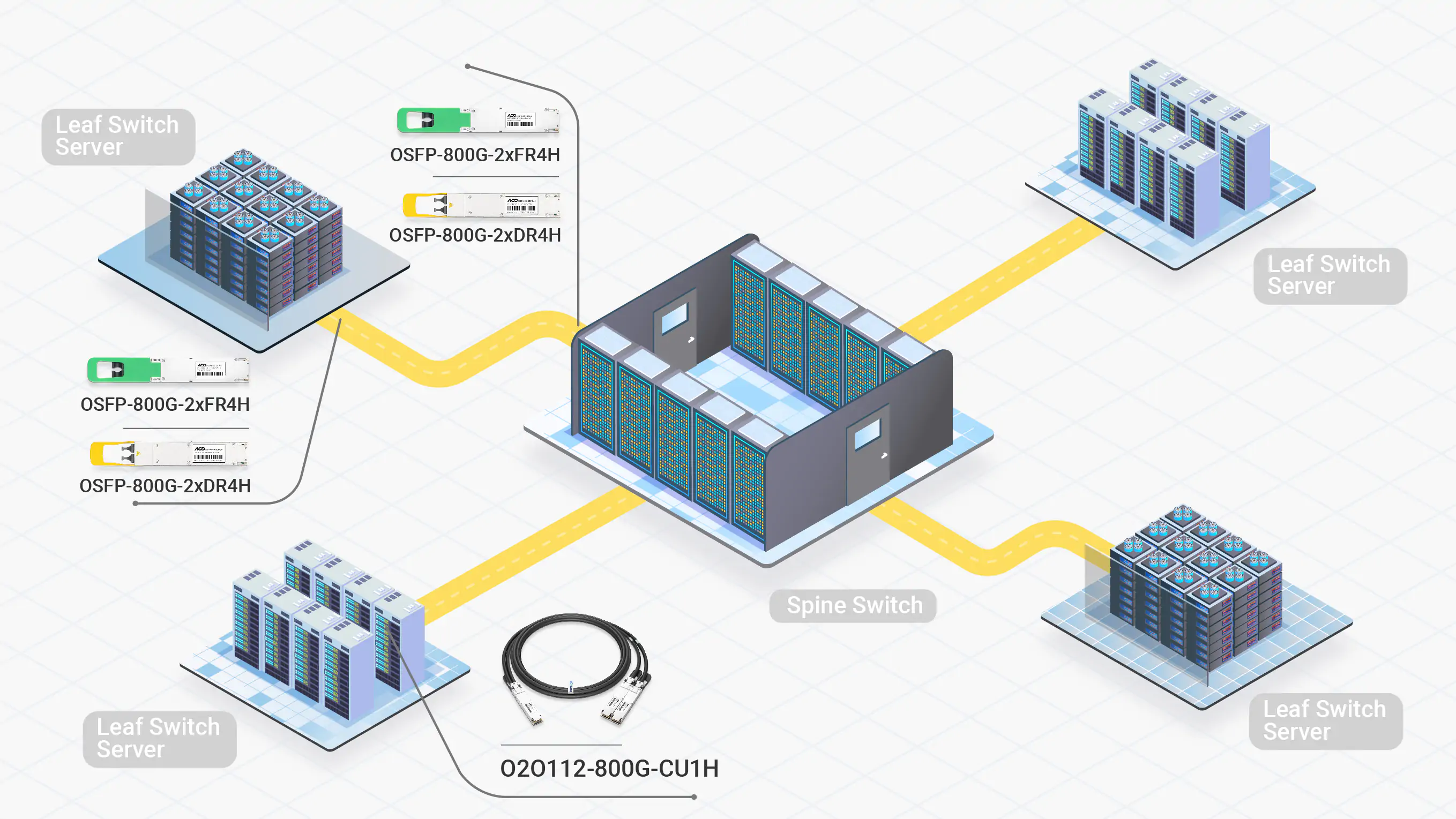

Répondre aux exigences extrêmes en matière de bande passante et de latence des modèles ultra-larges de plusieurs billions de paramètres.

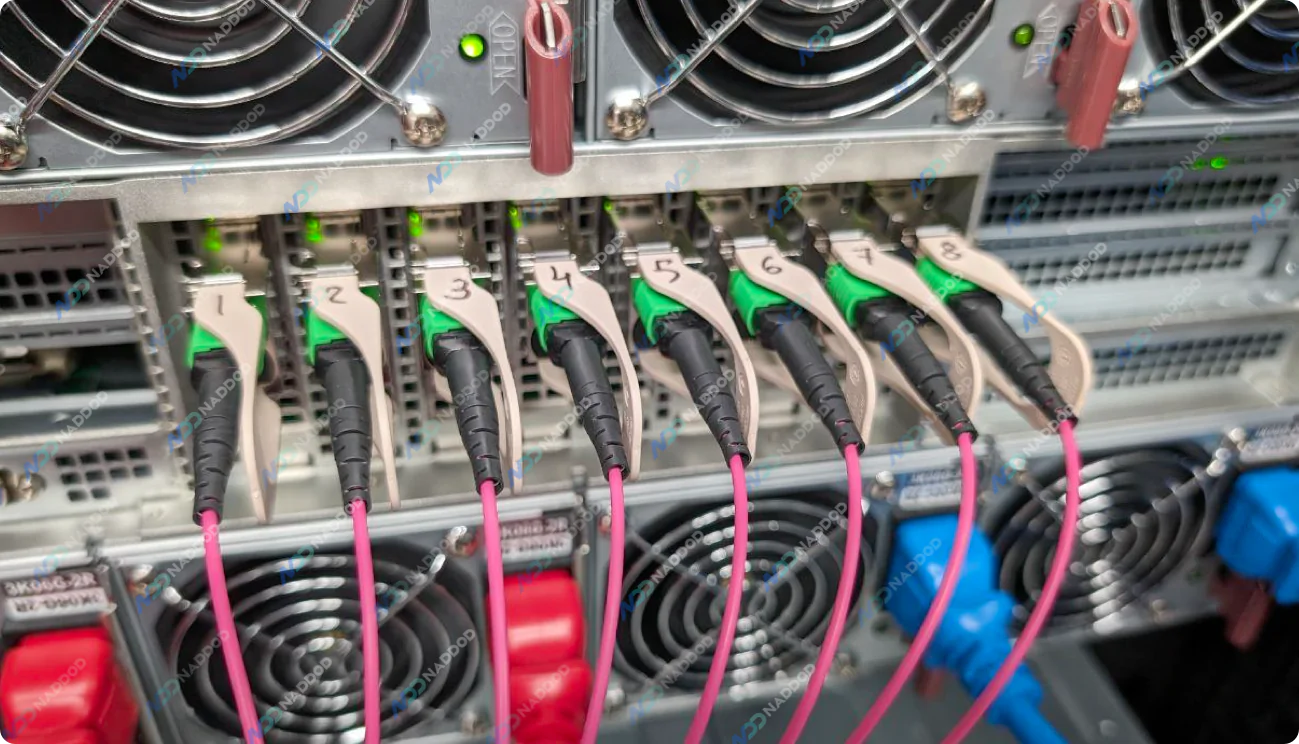

Pour les grands clusters d'IA, une approche hybride combinant des câbles DAC avec des émetteurs-récepteurs XDR ou NDR est couramment adoptée. Elle combine des vitesses ultra-élevées pour les charges de travail d'IA exigeantes avec une infrastructure rentable.

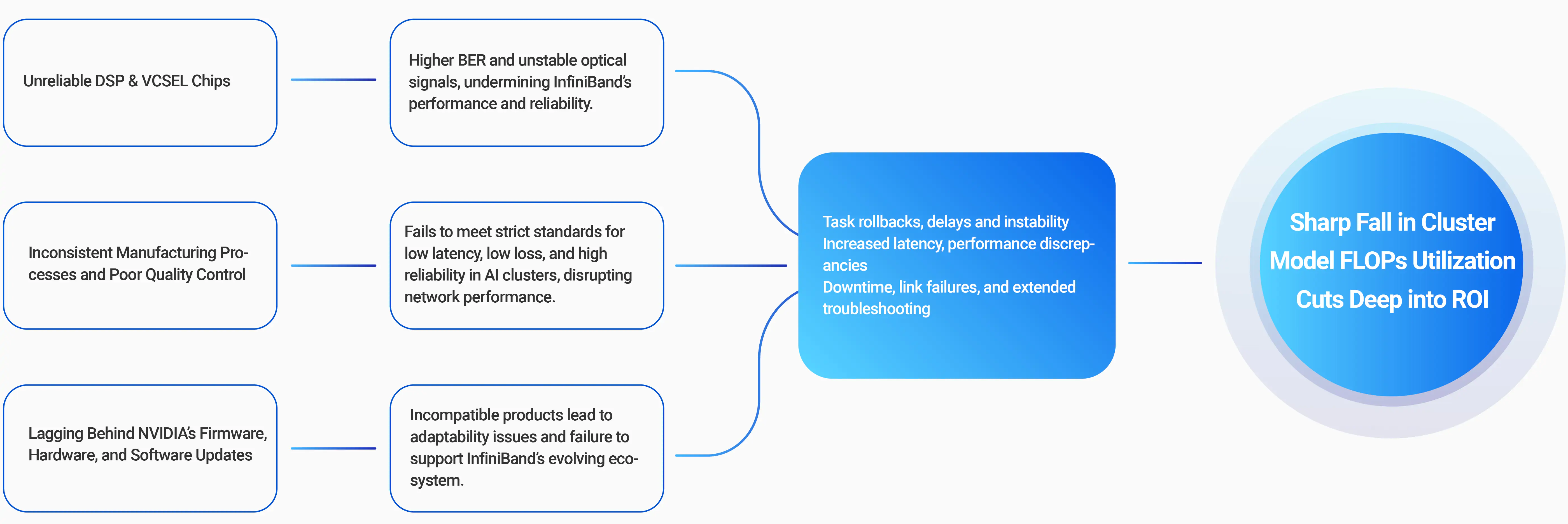

80 % des Interruptions de Formation à l'IA proviennent de Problèmes de Réseau.

95 % des problèmes réseau sont souvent liés à des interconnexions optiques défectueuses.

NVIDIA Quantum-X800 et Quantum-2, les options de connectivité permettent des topologies flexibles avec une variété de modules émetteurs-récepteurs, de connecteurs MPO, d'ACC et de DAC. La compatibilité descendante connecte les clusters 800 Gb/s et 400 Gb/s aux infrastructures 200 Gb/s ou 100 Gb/s existantes, assurant une évolutivité et une intégration transparentes.

InfiniBand XDR Optics and CablesLes NVIDIA Quantum‑X800 et Quantum‑2 sont conçus pour répondre aux exigences des réseaux IA et HPC hautes performances, offrant respectivement 800 Gb/s et 400 Gb/s par port, et sont disponibles en configurations refroidies par air ou par liquide pour s'adapter aux divers besoins des centres de données.

Commutateurs Quantum-X800L'adaptateur NVIDIA ConnectX-8 et ConnectX-7 InfiniBand offre des performances inégalées pour les charges de travail d'IA et de calcul haute performance (HPC), proposant un ou deux ports réseau avec des vitesses allant jusqu'à 800 Gb/s, disponibles dans plusieurs formats pour répondre aux divers besoins de déploiement.

Adaptateurs ConnectX-8

Associez-vous à NADDOD pour Accélérer Votre Réseau InfiniBand et Propulser l'Innovation en IA de Nouvelle Génération