NDR-Multimode-Transceiver-Bereitstellung

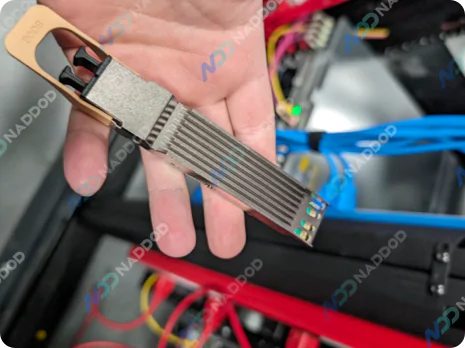

InfiniBand NDR-Multimode-Transceiver bieten kosteneffektive, zuverlässige Leistung für kurze Entfernungen.

Adaptives Routing, In-Network-Computing und Congestion-Control-Architektur ermöglichen es InfiniBand, den anspruchsvollen Anforderungen von HPC- und KI-Clustern gerecht zu werden. Diese Optimierungen gewährleisten nahtlosen Datenfluss, eliminieren Engpässe und ermöglichen effiziente Ressourcennutzung, was zu überlegener Leistung und betrieblicher Effizienz für komplexe Infrastrukturen führt.

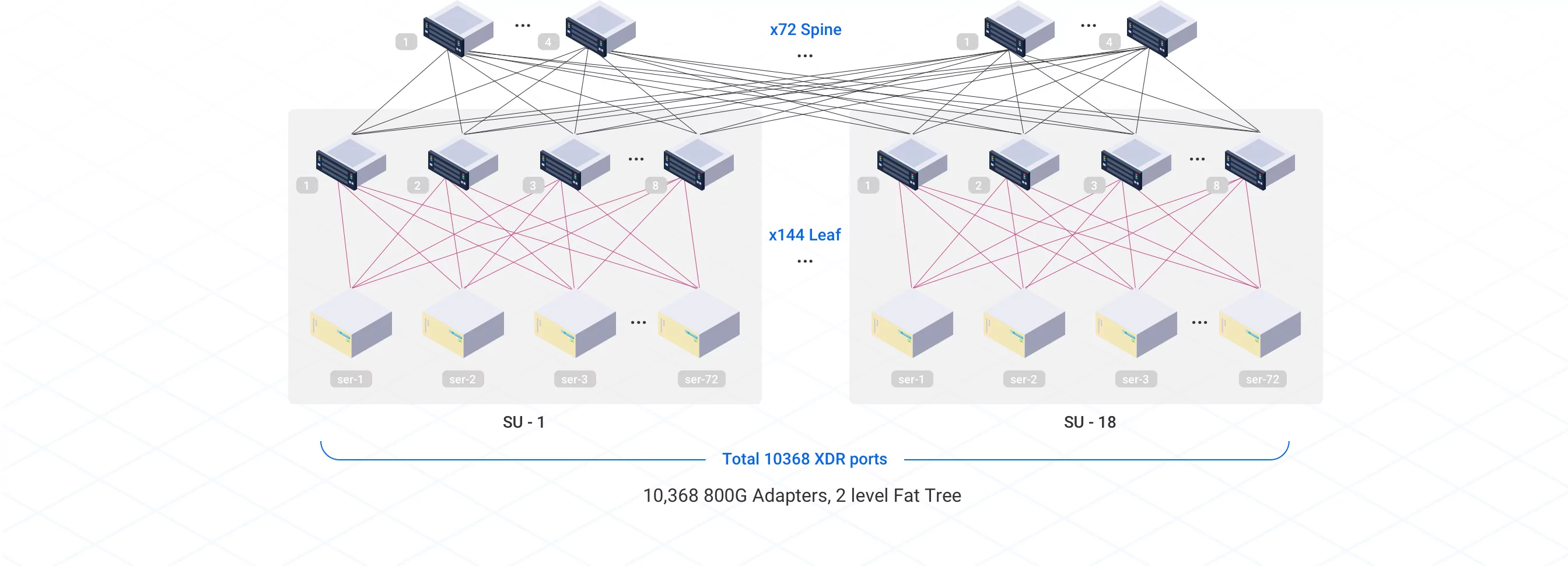

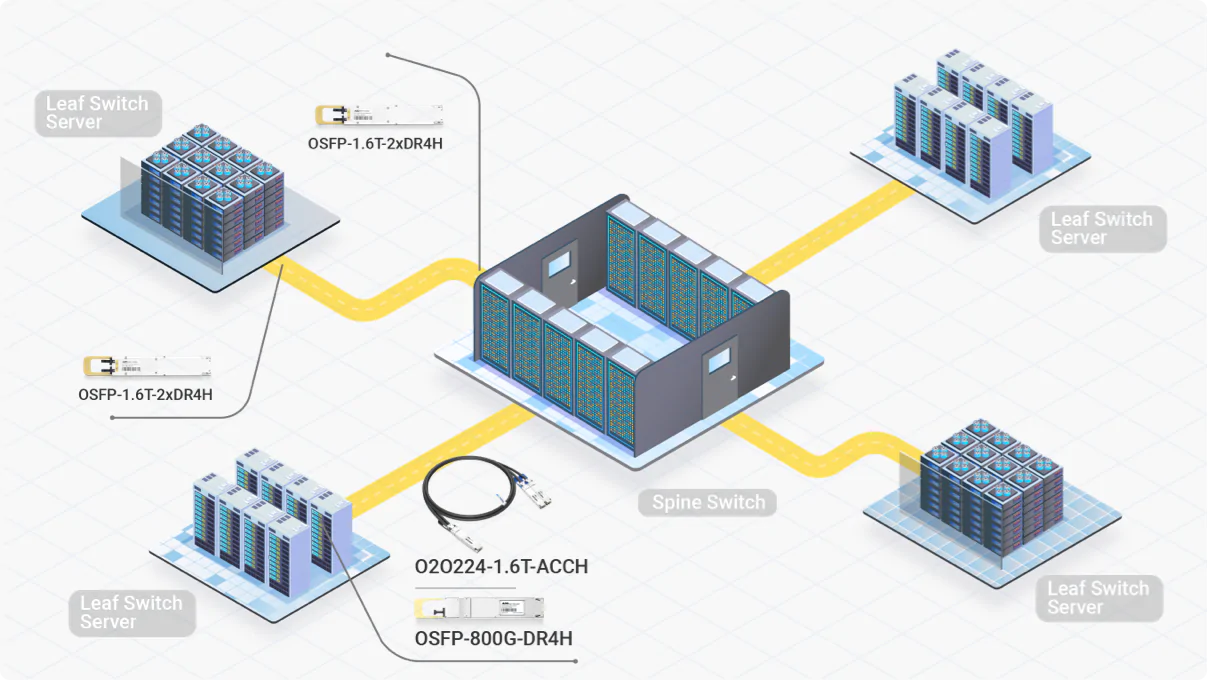

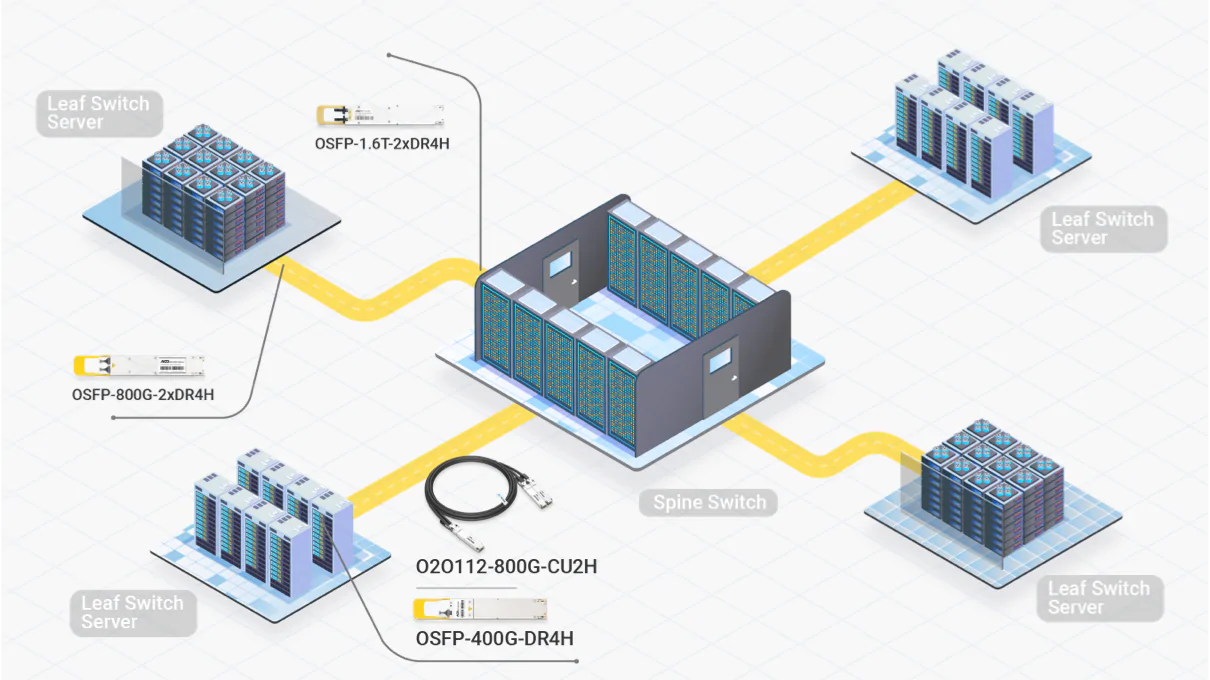

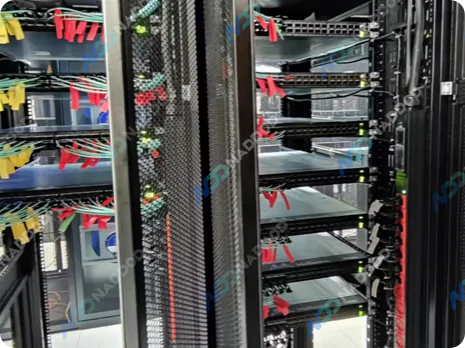

Für groß angelegte InfiniBand-KI-Cluster-Bereitstellungen mit NVIDIA H100, H200 GPUs, den DGX-Lösungen (GB200, GB300) wird die Fat-Tree-Netzwerktopologie mit diesen kombiniert, die für die Handhabung intensiver KI-Workloads geeignet sind.

Flexible Lösungen, die auf verschiedene KI-Clustergrößen, Rechenzentrumslayouts und Verbindungsentfernungen zugeschnitten sind.

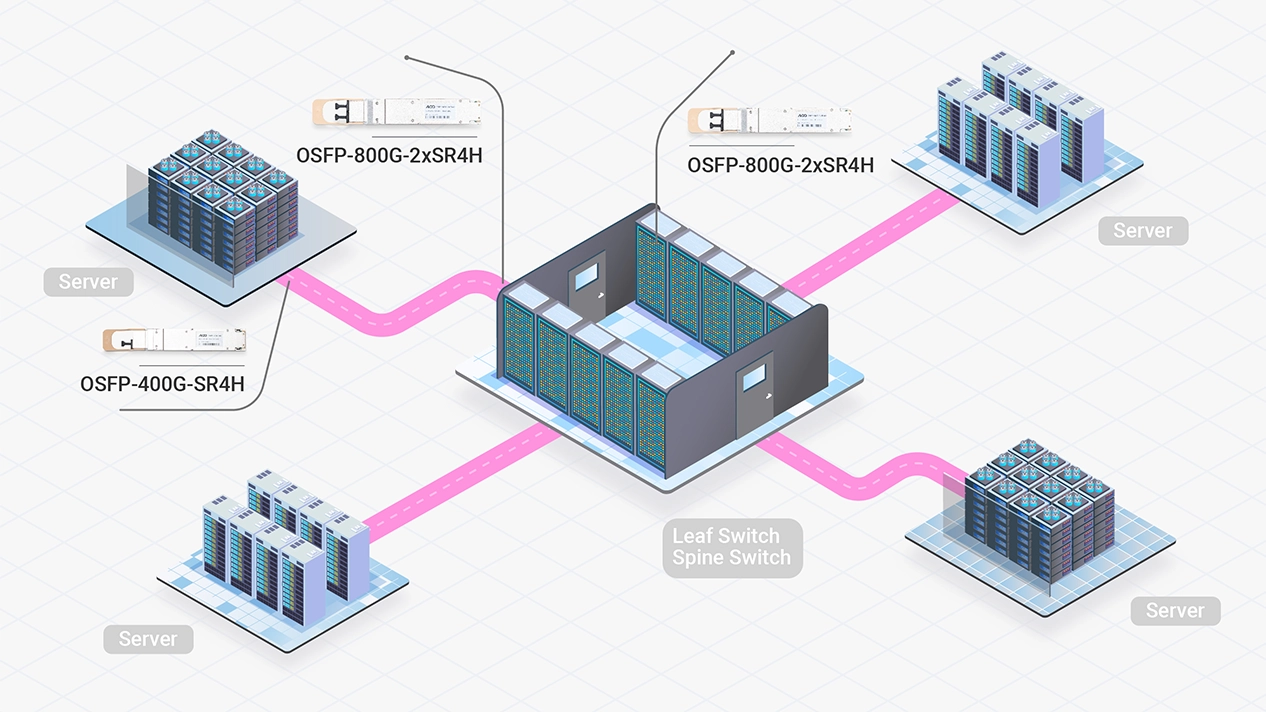

Hochleistungs-InfiniBand-Netzwerkbereitstellung für kompakte KI-Rechenzentren

InfiniBand NDR-Multimode-Transceiver bieten kosteneffektive, zuverlässige Leistung für kurze Entfernungen.

Hochleistungs- und kosteneffektive Möglichkeit, skalierbarere KI-Cluster zu aktualisieren oder zu erstellen.

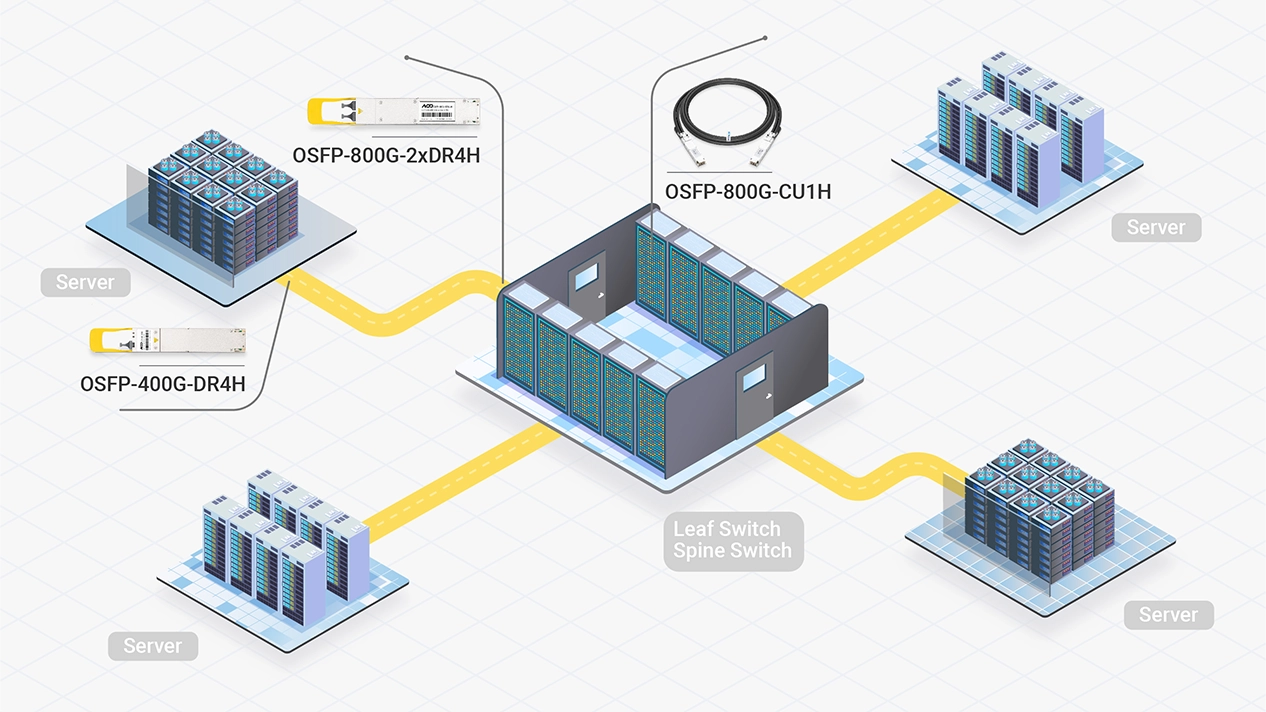

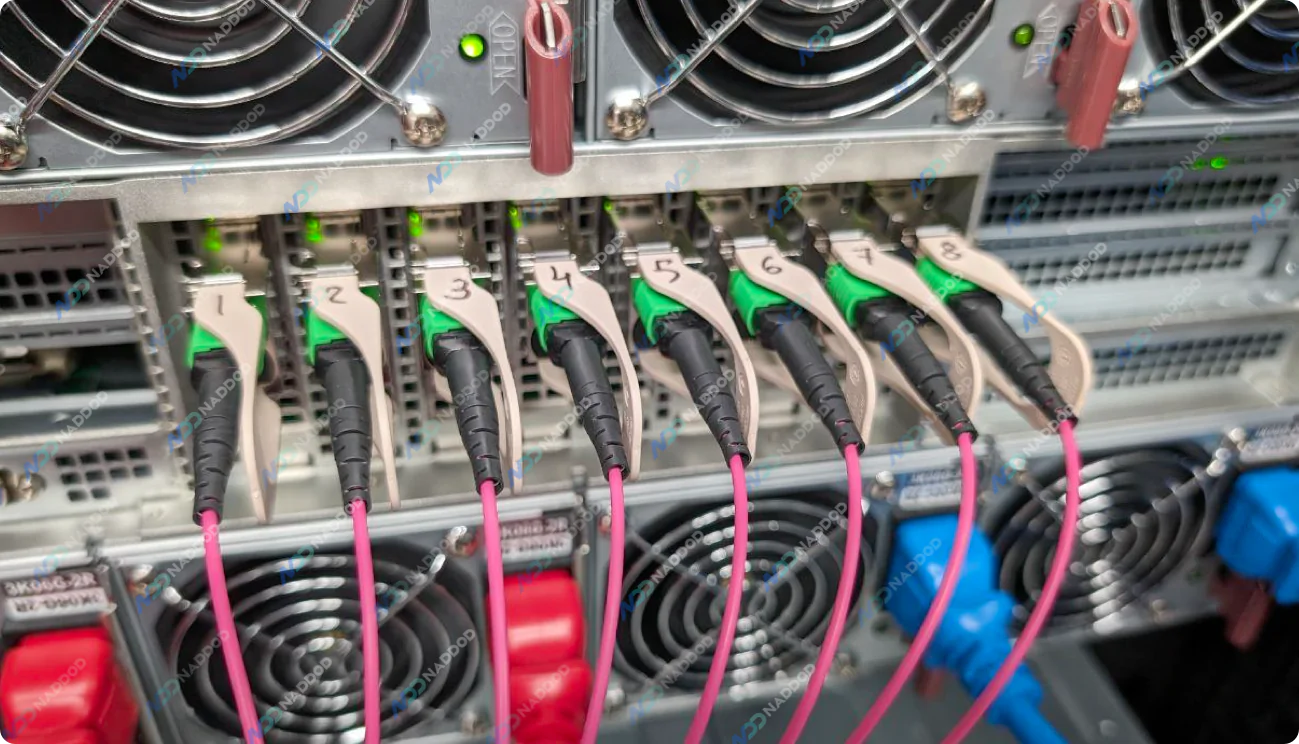

InfiniBand NDR-Single-Mode-Transceiver ermöglichen stabile, langstreckige Verbindungen, während DAC-Kabel die Kosten und den Stromverbrauch senken. Zusammen bieten sie eine effiziente Lösung für mittlere bis große Cluster.

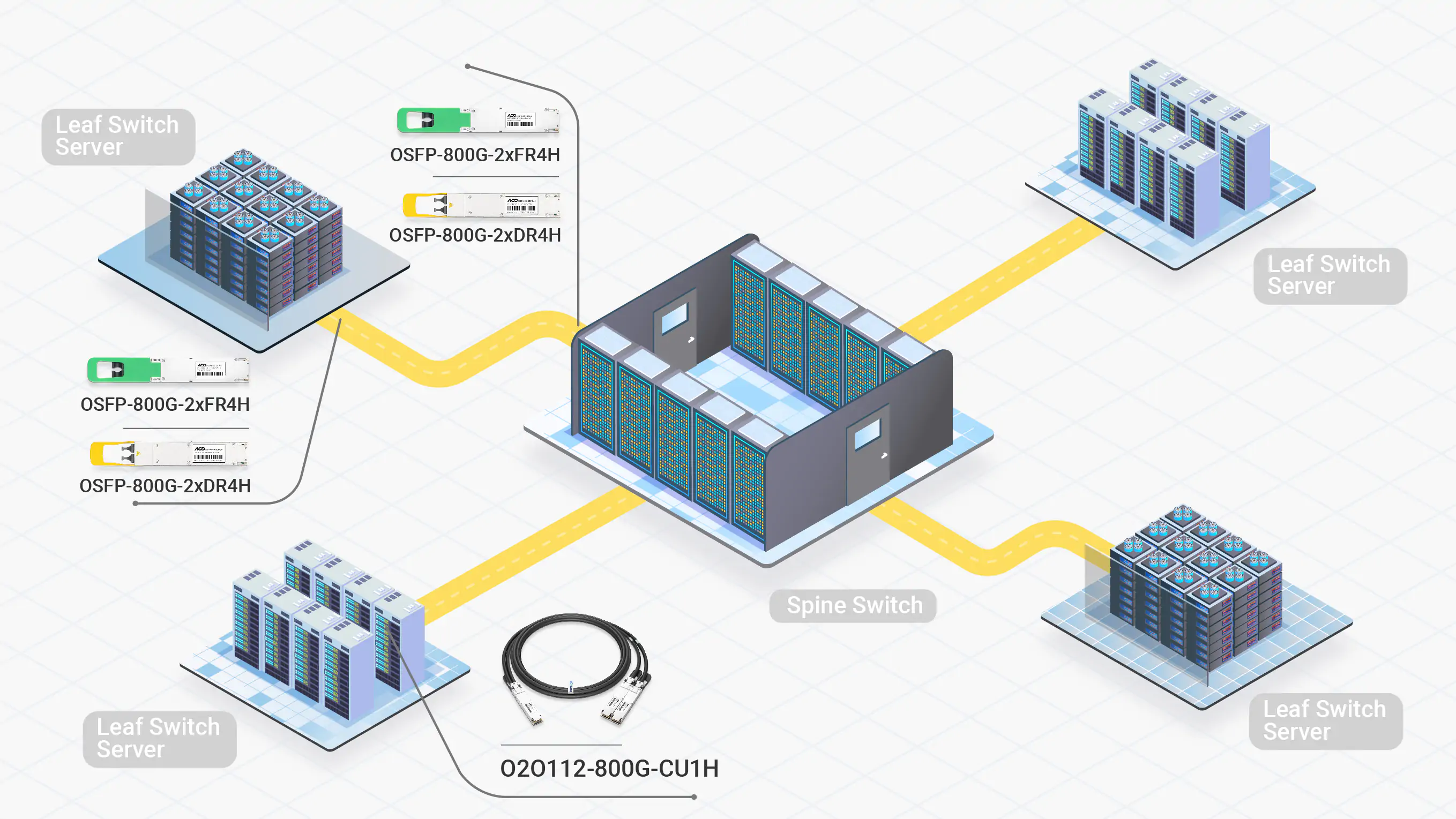

Erfüllung der extremen Bandbreiten- und Latenzanforderungen von Billionen-Parameter-Ultra-Großmodellen.

Für große KI-Cluster wird häufig ein Hybrid-Ansatz verwendet, der DAC-Kabel mit XDR- oder NDR-Transceivern kombiniert. Er kombiniert ultrahohe Geschwindigkeiten für anspruchsvolle KI-Workloads mit kosteneffizienter Infrastruktur.

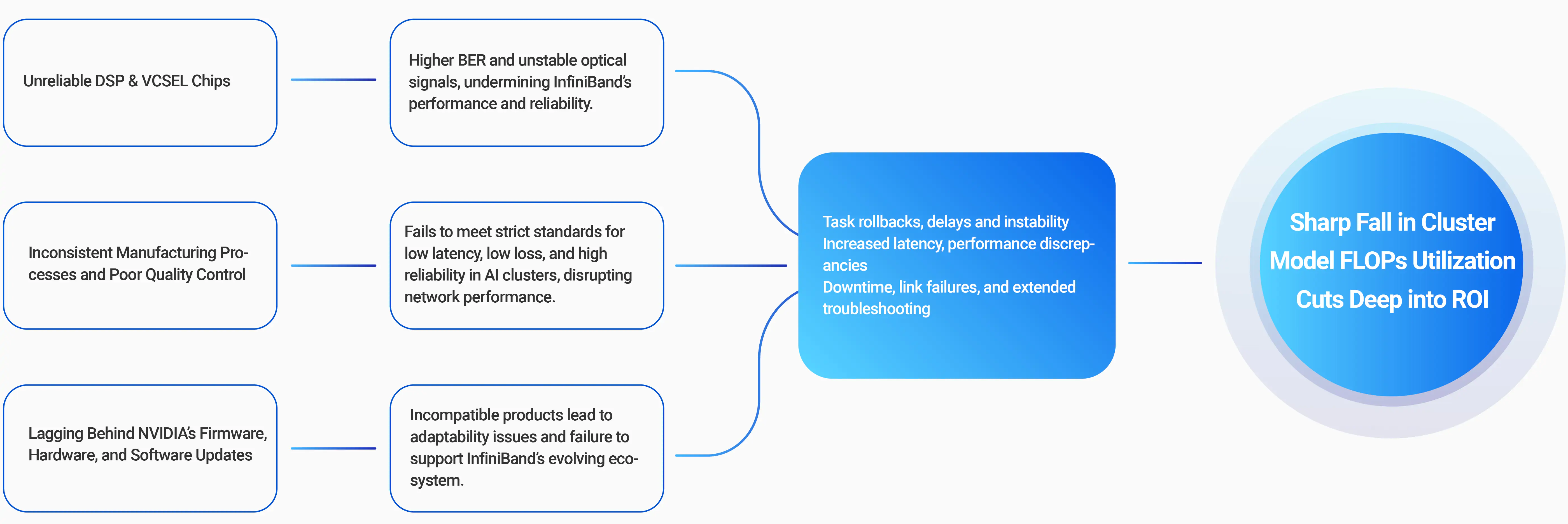

80% der KI-Trainingsunterbrechungen stammen von Netzwerkseitenproblemen

95% der Netzwerkprobleme sind oft mit fehlerhaften optischen Verbindungen verbunden

NVIDIA Quantum-X800- und Quantum-2-Konnektivitätsoptionen ermöglichen flexible Topologien mit einer Vielzahl von Transceivern, MPO-Steckverbindern, ACC und DACs. Rückwärtskompatibilität verbindet 800b/s- und 400Gb/s-Cluster mit bestehenden 200Gb/s- oder 100Gb/s-Infrastrukturen und gewährleistet nahtlose Skalierbarkeit und Integration.

InfiniBand XDR Optics and CablesDie NVIDIA Quantum-X800 und Quantum-2 sind darauf ausgelegt, die Anforderungen von Hochleistungs-KI- und HPC-Netzwerken zu erfüllen und bieten 800 Gb/s bzw. 400 Gb/s pro Port und sind in luftgekühlten oder flüssigkeitsgekühlten Konfigurationen verfügbar, um verschiedenen Rechenzentrumsanforderungen gerecht zu werden.

Quantum-X800-SwitchesDer NVIDIA ConnectX-8- und ConnectX-7-InfiniBand-Adapter bietet unvergleichliche Leistung für KI- und HPC-Workloads mit einzelnen oder doppelten Netzwerkports mit Geschwindigkeiten von bis zu 800Gb/s, verfügbar in mehreren Formfaktoren, um verschiedene Bereitstellungsanforderungen zu erfüllen.

ConnectX-8-Adapter

Partner mit NADDOD, um Ihr InfiniBand-Netzwerk für die nächste Generation von KI-Innovationen zu beschleunigen